Рекомендации по обучению нейронной сети

В этой главе мы поймем различные аспекты обучения нейронной сети, которые могут быть реализованы с использованием фреймворка TensorFlow.

Ниже приведены десять рекомендаций, которые можно оценить:

Обратное распространение

Обратное распространение — это простой метод вычисления частных производных, который включает базовую форму композиции, наиболее подходящую для нейронных сетей.

Стохастический градиентный спуск

В случае стохастического градиентного спуска (gradient descent), пакет — это общее количество примеров, которое пользователь использует для вычисления градиента за одну итерацию. До сих пор предполагается, что пакет был весь набор данных. Лучшая иллюстрация работает в масштабе Google; наборы данных часто содержат миллиарды или даже сотни миллиардов примеров.

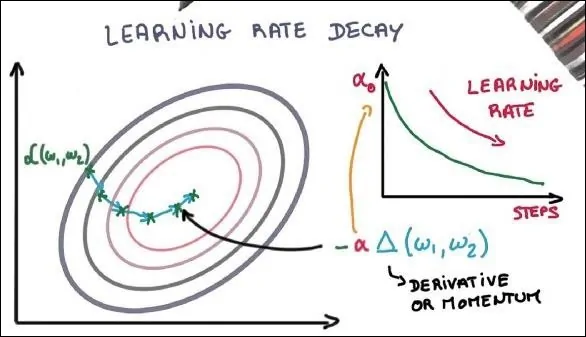

Скорость обучения

Адаптация скорости обучения является одной из наиболее важных функций оптимизации градиентного спуска. Это очень важно для реализации TensorFlow.

Отсев

Глубокие нейронные сети с большим количеством параметров образуют мощные системы машинного обучения. Однако переоснащение является серьезной проблемой в таких сетях.

Максимальный пул

Максимальный пул — это процесс дискретизации на основе выборки. Цель состоит в том, чтобы уменьшить выборку входного представления, что уменьшает размерность с необходимыми допущениями.

Долгосрочная кратковременная память (LSTM)

LSTM контролирует решение о том, какие входные данные должны быть приняты в пределах указанного нейрона. Он включает в себя элемент управления для принятия решения о том, что должно быть рассчитано и какой вывод должен быть создан.