Как будущее вычислительной техники может выглядеть непохожим ни на что ранее

Наш современный мир был бы невообразим без компьютеров. Все, что мы делаем, от проверки погоды и просмотра социальных сетей до производства товаров и ведения бизнеса, опирается на технологический фундамент, который начал формироваться много десятилетий назад. Современные цифровые компьютеры действительно построены в соответствии с принципами проектирования, предложенными математиком Джоном Фон Нейманом в 1940-х годах. В архитектурном проекте фон Неймана обработка данных происходит в центральном процессоре (CPU), а данные и программы заключены в физически разделенном аппаратном обеспечении, называемом памятью.

В то время архитектура фон Неймана оказалась более выгодной по сравнению с альтернативными моделями, но с быстрым распространением искусственного интеллекта ее недостатки становятся все более очевидными. Пересылка данных между памятью и процессором обходится дорого с точки зрения как энергопотребления, так и скорости при выполнении вычислений ИИ. Это особенно актуально при обучении моделям глубокого обучения, которые требуют частого обновления параметров модели.

Учитывая этот бум искусственного интеллекта, исследователи IBM ищут альтернативные аппаратные архитектуры, которые лучше соответствуют требованиям рабочих нагрузок искусственного интеллекта. Одним из шаблонов является человеческий мозг, который сам по себе является чрезвычайно сложным, но эффективным вычислительным устройством. Потребляя всего около 20 Вт средней потребляемой мощности, наш мозг преуспевает, когда дело доходит до решения сложных задач с минимальными затратами энергии.

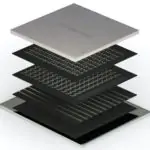

Одним из наиболее перспективных подходов, имитирующих работу мозга, являются вычисления в памяти (IMC). Идея, лежащая в ее основе, проста, но эффективна: вместо того, чтобы иметь отдельные ячейки для памяти и обработки, операции выполняются в самой памяти. Это устраняет необходимость постоянного перемещения данных и обеспечивает более быстрый доступ к сохраненным данным. Способ реализации IMC заключается в создании массива “проводов”, каждая точка пересечения которого представляет единицу памяти. Выбор правильного материала имеет решающее значение. Популярным материалом для изготовления проводов являются материалы с фазовым переходом. У них есть электрическое сопротивление, которое можно изменить, нагревая или охлаждая их, что заставляет материалы переходить от кристаллической структуры с высокой проводимостью к изолирующей аморфной атомной структуре.

Исследователь IBM Абу Себастьян недавно был назначен членом Института инженеров электротехники и электроники (IEEE) за его значительный вклад в область вычислений в памяти. Он поделился с нами своими мыслями о своей карьере, текущем состоянии вычислений в памяти и о том, куда, по его мнению, движется технология.

Вас только что назвали стипендиатом IEEE за ваш вклад в область вычислений в памяти. Объясните мне, чем это отличается от того, как работают наши традиционные цифровые компьютеры?

Наша текущая вычислительная парадигма борется с двумя сходящимися тенденциями: замедлением традиционных законов масштабирования полупроводников и взрывным ростом искусственного интеллекта, который подпитывается алгоритмами, требующими больших вычислительных ресурсов, такими как глубокое обучение. Это приводит к двум большим проблемам: быстро растущему потреблению энергии наряду со стагнацией задержек, связанных с вычислениями.

Решение этих проблем требует срочности, и вычисления в памяти могут обеспечить путь вперед. Когда дело доходит до энергоэффективности, естественным местом для поиска ответов является человеческий мозг, замечательный механизм обработки информации, который потребляет так же мало энергии, как электрическая лампочка. В этом контексте особенно привлекательны две особенности того, как мозг обрабатывает информацию: во-первых, нейроны и синаптические веса в мозге неподвижны, а потоки данных проходят через физически подключенную нейронную сеть. Во-вторых, как синаптическое взвешивание, так и распространение активации выполняются с ограниченной арифметической точностью в аналоговой области. Эти два свойства формируют основу для вычислений в памяти, где мы используем физические атрибуты устройств памяти и их организацию для выполнения приближенных вычислений, часто в аналоговой области.

Термин “стена памяти” относится к ограничению современных цифровых компьютеров, которое могут помочь преодолеть вычисления в памяти. Что означает этот термин и как ваши исследования могут устранить это фундаментальное узкое место?

В традиционных цифровых компьютерах существует физическое разделение между памятью и обработкой, что означает, что данные необходимо перемещать взад и вперед между двумя устройствами. На протяжении многих лет процессоры становились быстрее и энергоэффективнее очень быстро, в то время как доступ к памяти и передача данных сильно отставали до такой степени, что даже если обработка требует нулевой энергии, мы все равно в конечном итоге тратим много энергии и времени на простой доступ и перемещение данных туда и обратно. Это называется стеной памяти. Как следует из названия, вычисления в памяти напрямую решают эту проблему путем вычислений в самой памяти.

Давайте вернемся немного назад. Что привело вас в IBM Research?

Во время моей докторской диссертации я обучался математической инженерии, которая, среди прочего, охватывает теорию управления, обработку сигналов и коммуникации. Это послужило основой, когда я начал заниматься различными областями исследований. Мое первоначальное увлечение было связано с наномасштабной динамикой и контролем, что привело меня в исследовательскую лабораторию IBM в Цюрихе для работы над громким проектом под названием Millipede. Во время моей докторской диссертации и первых лет работы в IBM я внес важный вклад в области нанопозиционирования, наномасштабного зондирования и атомно-силовой микроскопии.

Однако я все больше увлекался наноэлектронными устройствами, особенно теми, которые могут хранить информацию с точки зрения их атомарных конфигураций, таких как память с фазовым переходом. В течение почти десяти лет, наполненных большим удовольствием, моя команда и я внесли ключевой вклад в понимание различных аспектов физики устройств PCM. Мы также представили новые способы проектирования устройств PCM и предложили использовать более простые материалы с наноразмерным ограничением для решения проблемы сброса тока. Мы также представили новые способы записи и считывания информации на устройствах PCM.

Как вы заинтересовались вычислениями в памяти?

Около восьми лет назад мы все больше увлекались зарождающейся областью вычислений в памяти и чувствовали, что благодаря нашей ведущей роли в технологии PCM, в частности нашему опыту в хранении значений аналоговой проводимости в отдельных устройствах PCM, мы могли бы внести существенный вклад в эту область. Я также получил грант Европейского исследовательского совета, который дал значительный импульс этой работе.

В последующие годы мы продемонстрировали способы реализации как синаптических, так и нейронных элементов с использованием устройств PCM и разработали способы достижения эквивалентной программному обеспечению точности классификации как для вывода, так и для обучения. Мы также продемонстрировали несколько применений вычислений в памяти в научных вычислениях, обработке сигналов, накопительных вычислениях, запросах к базе данных и гиперпространственных вычислениях. И с помощью недавно созданного IBM Research AI Hardware Center и глобальные исследовательские группы IBM доказали многие из этих концепций в кремнии, создав несколько поколений вычислительных чипов в памяти с использованием технологии 90 нм и 14 нм CMOS со встроенным PCM. Вместе с внешними сотрудниками мы могли бы также расширить область до фотонной области.

Какие, на ваш взгляд, наиболее перспективные реализации вычислений в памяти?

Иногда вычисления в памяти также относятся к подходам, при которых некоторые цифровые логические операции выполняются прямо рядом с фрагментом памяти, обычно на том же чипе памяти. В более узкой версии вычислений в памяти, над которой мы работаем, мы выполняем вычисления коллективно в памяти без необходимости считывать содержимое отдельной памяти. В этой категории наиболее продвинутые из них используют вычислительные элементы на основе статической оперативной памяти (SRAM). Однако SRAM является нестабильным, что означает потерю сохраненной информации при отключении питания. Кроме того, с SRAM будет непросто иметь гигабайты встроенной памяти. Напротив, PCM и резистивная оперативная память (RRAM) сохраняют свою информацию даже при отключении питания и потенциально могут обеспечить более высокую плотность обработки. Однако настоящим изменением было бы, если бы для вычислений в памяти можно было использовать некоторую объемную память 3D, поскольку это значительно увеличило бы весовую емкость.

Где сегодня находятся вычисления в памяти?

Вычисления в памяти — очень активная область исследований, как в академических кругах, так и в промышленности. Основные конференции по электронике, такие как ISSCC, IEDM и VLSI, регулярно проводят несколько сессий, посвященных вычислениям в памяти. Взрывной рост ИИ также стимулирует исследования в области IMC. Большая часть первоначальной работы по вычислениям в памяти была основана на моделировании, данных с одного устройства или небольших тестовых чипах. В последнее время мы видим все более сложные, полностью интегрированные чипы, в том числе те, которые разработаны и изготовлены в аппаратном центре IBM Research AI. Есть даже несколько стартапов, которые продемонстрировали несколько впечатляющих прототипов.

Каким вы видите развитие технологии в ближайшие пять-10 лет? Какие задачи стоят впереди?

В ближайшие несколько лет я предвижу еще много технических достижений, таких как повышенная точность и плотность вычислений, высокооптимизированные периферийные схемы и оптимально спроектированные вычислительные системы с ядрами IMC, эффективно интегрированными с остальными цифровыми вычислительными блоками в единой системе.

Самой большой проблемой будет разрушение существующей аппаратной и программной инфраструктуры, которая была создана за последние полвека. Однако мы достигли точки, когда необходимо опробовать новаторские идеи, не только для снижения затрат на вычислительную энергию, но и для создания новых приложений. Например, что, если бы наши телефоны могли переводить на несколько языков в режиме реального времени без доступа к облачным ресурсам или если бы мы могли запускать большую языковую модель, такую как GPT-3, в тостере, как недавно предложил Джефф Хинтон? Такие области, как автономное вождение, робототехника, финансы и медицина, получат выгоду от этих возможностей. IMC также поддается новым парадигмам ИИ, которые выходят за рамки глубокого обучения. Вот почему я довольно оптимистично смотрю в будущее IMC.

Наконец, какой совет вы бы дали молодому исследователю, заинтересованному в этой области?

Вычисления в памяти — это междисциплинарная область с множеством интересных проблем, которые еще предстоит решить. Я бы настоятельно рекомендовал молодым исследователям, начинающим работать в этой области, сначала изучить фундаментальные открытые вопросы и попытаться решить их, а не ориентироваться на потенциально привлекательный вклад, который в долгосрочной перспективе может оказать незначительное влияние на область.

Источник: https://research.ibm.com/blog/abu-sebastian-ieee-in-memory-computing

Редактор: AndreyEx