Как оптимизировать Robots.txt для SEO в WordPress

Вы хотите оптимизировать свой файл robots.txt в WordPress? Не уверены, почему и каким образом файл robots.txt имеет важное значение для вашего SEO? В этой статье расскажем вам, как оптимизировать ваш файл robots.txt на сайте WordPress для SEO и поможем вам понять важность файла robots.txt.

В последнее время, пользователи спрашивают нас, нуждаются ли сайт в файле robots.txt и какова важность его? Файл robots.txt для вашего сайта играет важную роль в общей производительности и seo оптимизации вашего сайта. Это в основном позволяет вам общаться с поисковыми системами и дают им знать, какие части вашего сайта они должны индексировать.

Нужен ли файл robots.txt?

Отсутствие файла robots.txt не остановит поисковых систем от сканирования и индексирования вашего сайта. Тем не менее, настоятельно рекомендуется создать один. Если вы хотите представить на вашем сайте в XML карту сайта для поисковых систем, то в файле поисковые системы будут искать ваш XML Sitemap, если вы не указали его в Yandex webmaster или Google Webmaster Tools.

Мы настоятельно рекомендуем, если у вас нет файла robots.txt на вашем сайте, то вы должны сразу же создать.

Где находится файл robots.txt? Как создать файл robots.txt?

Файл robots.txt, как правило, находится в корневой папке вашего сайта. Вам нужно будет подключиться к вашему сайту с использованием клиента FTP или с помощью файлового менеджера CPanel для его просмотра.

Он такой же, как любой обычный текстовый файл, и вы можете открыть его с помощью обычного текстового редактора как Блокнота.

Если у вас нет файла robots.txt в корневом каталоге вашего сайта, то вы всегда можете создать. Все, что вам нужно сделать, это создать новый текстовый файл на вашем компьютере и сохранить его в файле robots.txt. Далее, просто загрузите его в корневую папку вашего сайта.

Как использовать файл robots.txt?

Формат файла robots.txt на самом деле довольно прост. Первая строка обычно называет User-Agent. Агент пользователя на самом деле имя бота поисковой системы, которые пытаются прочитать ваш сайт. Например, Googlebot или Yandexbot. Вы можете использовать звездочку *, чтобы проинструктировать всех ботов.

В следующей строке следует разрешить или запретить инструкции для поисковых систем, чтобы они знали, какие части вы хотите, чтобы индексировались, и какие из них вы не хотите индексировать.

Смотрите пример файла robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html

В этом примере файл robots.txt для WordPress, мы поручили всем ботам индексировать наш каталог загрузки изображения.

В следующих двух строках мы им запрещаем индексировать наш каталог плагинов WordPress и файл readme.html.

Оптимизация файла Robots.txt для SEO

В руководстве для веб-мастеров, Google советует веб-мастерам, не использовать файл robots.txt, чтобы скрыть содержание низкого качества. Если вы думаете об использовании файла robots.txt, чтобы остановить Google индексировать категории, даты и другие архивные страницы, то это не может быть мудрым выбором.

Помните, что цель robots.txt является поручить ботам, что делать с содержанием, когда они сканируют ваш сайт. Это не помешает ботам сканировать ваш сайт.

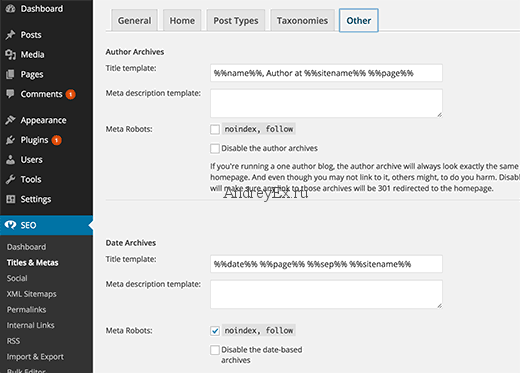

Есть и другие плагины для WordPress, которые позволяют добавлять мета-теги, как NOFOLLOW и мета тег noindex в ваших страницах архива. Плагин WordPress SEO также позволяет сделать это. Мы не говорим, что вы должны иметь ваши архивные страницы deindexed, но если вы хотите сделать это, то, что правильный способ сделать это.

Вам не нужно добавлять страницу логина, каталога администратора или страницу регистрации в robots.txt, потому что логин и регистрационные страницы имеют теги NOINDEX, которые уже добавлены как мета-тег с помощью WordPress.

Он рекомендуется запретить readme.html файл в файле robots.txt. Этот файл readme может быть использован кем-то, кто пытается выяснить, какую версию WordPress вы используете. Если бы это было физическое лицо, то они могут легко получить доступ к файлу, просто просматривая его.

С другой стороны, если кто-то работает с вредоносными запросами, чтобы найти сайты на WordPress с использованием конкретной версии, то этот тег Disallow может защитить вас от этих массовых атак.

Вы также можете запретить ваш каталог плагинов WordPress. Это будет способствовать укреплению безопасности вашего сайта, если кто-то ищет конкретный уязвимый плагин, чтобы использовать его для массовой атаки.

Добавление вашей XML Sitemap в файл robots.txt

Если вы используете плагин Йоаст в WordPress SEO или какой — либо другой плагин для генерации XML Sitemap , то ваш плагин будет пытаться автоматически добавлять связанные строки в вашем файле Sitemap в файл robots.txt.

Однако, если это не удается, то ваш плагин покажет вам ссылку на XML Sitemaps, который вы можете добавить в свой файл robots.txt вручную следующим образом:

Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Как должен выглядеть идеальный файл robots.txt?

Честно говоря, многие популярные блоги используют очень простые файлы robots.txt. Их содержание варьируются в зависимости от потребностей конкретного сайта:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Этот файл robots.txt просто сообщает всем ботам индексировать все содержание и предоставляет ссылки на XML Sitemaps сайта.

Вот еще один пример файла robots.txt, на этот раз это тот, который мы используем здесь на AndreyEx.ru:

User-agent: * Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-trackback Disallow: /wp-feed Disallow: /wp-comments Disallow: */trackback Disallow: */feed Disallow: */comments Disallow: /wp-login.php Disallow: /login.php Disallow: /wp-register.php Host: https://AndreyEx.ru User-agent: Googlebot Allow: /wp-content/plugins Allow: /wp-content/cache Sitemap: https://AndreyEx.ru/sitemap_index.xml

Это все. Мы надеемся , что эта статья помогла вам узнать , как оптимизировать ваш файл robots.txt для SEO. Вы также можете увидеть наш путеводитель по 9 лучшим WordPress SEO плагинам и инструментам, которые вы должны использовать.

Редактор: AndreyEx