OpenAI выпускает gpt-oss, модели расширенного мышления с открытым исходным кодом

OpenAI представила gpt-oss-120b и gpt-oss-20b, две модели расширенного мышления, “с доступными весами, обеспечивающие стабильную производительность в реальном мире при низких затратах” и которые, по заявлению компании, выпущены под лицензией Apache 2.0, что делает их открытыми. исходный код.

OpenAI объясняет, что “gpt-oss-120b находится на близком паритете с OpenAI o4-mini в базовых тестах логического мышления, эффективно работая на одном графическом процессоре емкостью 80 ГБ”. Со своей стороны, “модель gpt-oss-20b дает результаты, аналогичные OpenAI o3‑mini, в обычных тестах и может работать на периферийных устройствах с объемом памяти всего 16 ГБ, что делает ее идеальной для сценариев использования на устройстве, локального вывода или быстрой итерации без дорогостоящей инфраструктуры”.

Учитывая уже изложенное, логично предположить, что gpt-oss-120b и gpt-oss-20b ориентированы на разные контексты: первый больше ориентирован на профессиональную и деловую среду, а второй более совместим с более скромными командами, что должно привести к более высоким шансам на работу в одной команде. отечественный.

Углубляясь в требования и как опубликовано OpenAI в репозитории GitHub, посвященном двум недавно представленным моделям, необходимо иметь Python 3.12, в macOS предлагается использовать инструменты командной строки Xcode, в Linux для эталонной реализации требуется CUDA от NVIDIA, а в Windows они еще не были реализованы. были протестированы, хотя можно использовать Ollama для их локального запуска.

Компания, возглавляемая Сэмом Альтманом, также объясняет, что “модели прошли постобучение с использованием процесса, аналогичного тому, который использовался для o4-mini, который включает этап контролируемой настройки и этап интенсивного обучения с подкреплением”. Цель этого “состояла в том, чтобы привести модели в соответствие со спецификацией модели OpenAI Model Spec и научить вас применять цепные рассуждения (CoT) и использование инструментов перед созданием ответа. Используя те же методы, что и наши современные несвободные модели мышления (SoTA), модели демонстрируют исключительные возможности после посттренировочного обучения”.

Модели прошли постобучение в соответствии с форматом подсказок OpenAI harmony, и компания опубликовала средство визуализации harmony с открытым исходным кодом на Python и Rust, чтобы облегчить их внедрение. Существуют также “эталонные реализации для выполнения логических выводов с помощью PyTorch и на платформе Apple Metal, а также примеры инструментов для модели”.

OpenAI заявляет, что “выпуск gpt-oss-120b и gpt-oss-20b представляет собой значительный шаг вперед для моделей с доступным весом. Учитывая их размер, эти модели значительно улучшают как возможности рассуждения, так и безопасность. Добавляя эти открытые модели в наше текущее предложение API, мы стремимся ускорить передовые исследования, стимулировать инновации и обеспечить более безопасную и прозрачную разработку ИИ в самых разных сценариях использования”. Другие цели — снизить барьеры для развивающихся рынков и создать здоровую модель открытых моделей, чтобы сделать искусственный интеллект доступным и полезным для всех.

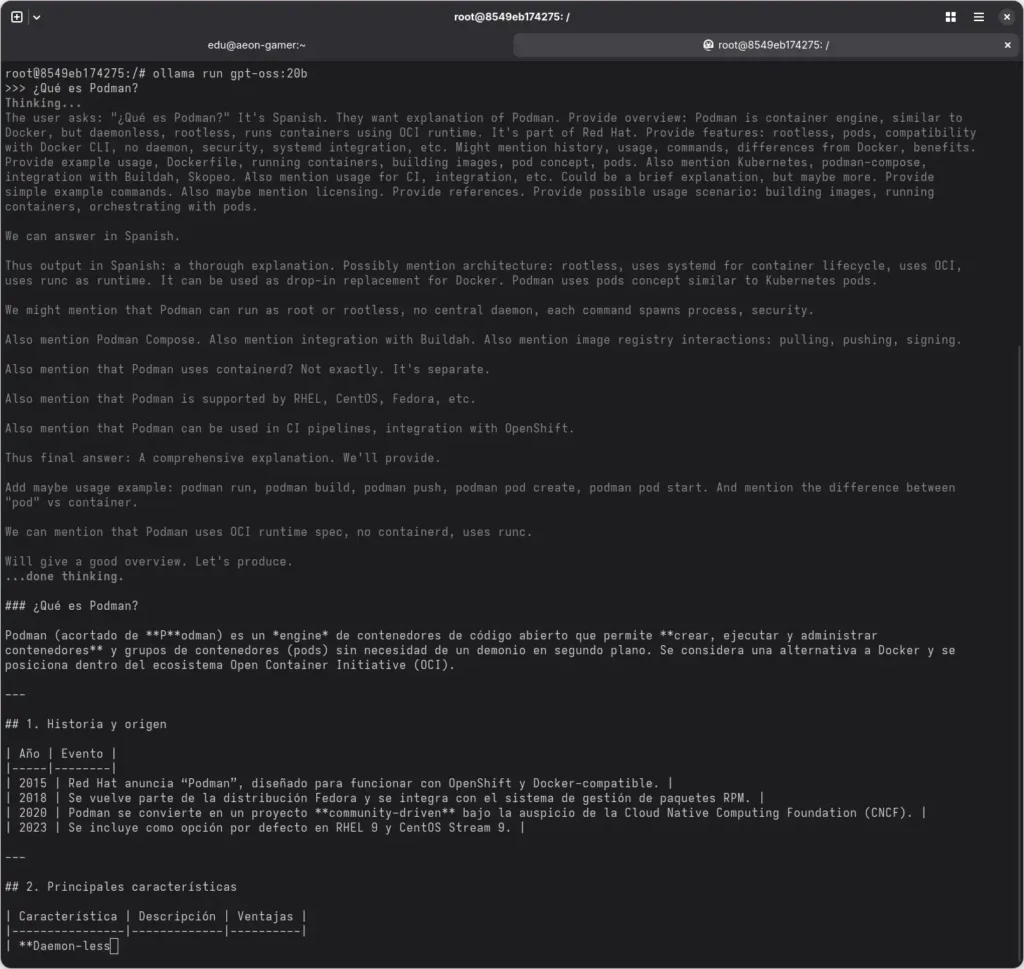

Как использовать gpt-oss-20b с Podman

После изложения наиболее важных аспектов gpt-oss-120b и gpt-oss-20b мы собираемся научить, как установить второй через Ollama с помощью контейнера Docker, запущенного поверх Podman.

Сначала необходимо установить и запустить контейнер Ollama, доступный в Docker Hub, следующим образом в Podman:

podman run -d -v /subdirectorio/en/tu/directorio/personal:/root/.ollama:z --network=bridge -p 11434:11434 --name contenedor-ollama docker.io/ollama/ollama

Важно отметить, что эти инструкции предназначены для системы GNU/Linux на базе openSUSE или Fedora, которая использует SELinux в качестве модуля безопасности, следовательно, тот:z, который указан в конце установленного тома. С другой стороны, /subdirectorio/en/tu/directorio/personalего необходимо заменить путем, который пользователь хочет использовать для хранения моделей в своем домашнем каталоге, что в моем случае было бы /home/eduсвязано с тем, что я сейчас использую Aeon Desktop.

Второй шаг — получить доступ к самому контейнеру, что делается следующим образом:

podman exec -it contenedor-ollama /bin/bash

Оказавшись внутри контейнера, мы локально устанавливаем модель gpt-oss-20b с помощью этой команды:

ollama pull gpt-oss:20b

А после установки модели ее можно запустить для выполнения запросов:

ollama run gpt-oss:20b

Важно отметить, что для выполнения этих действий рекомендуется относительно мощное оборудование с объемом оперативной памяти не менее 16 ГБ. В случае этого сервера компьютер оснащен процессором Intel Core i5-12600K, 32 ГБ оперативной памяти DDR4 с частотой 3200 МГц с использованием XMP и Radeon RX 7600 емкостью 8 ГБ.

Редактор: AndreyEx

Важно: Данная статья носит информационный характер. Автор не несёт ответственности за возможные сбои или ошибки, возникшие при использовании описанного программного обеспечения.