В нашей повседневной жизни мы часто используем метод дерева решений для принятия решений. Аналогичным образом, организации используют контролируемые методы машинного обучения, такие как деревья решений, для улучшения процессов принятия решений и увеличения общего профицита и прибыли.

Методы ансамбля объединяют несколько деревьев решений для получения более точных результатов прогнозирования по сравнению с использованием только одного дерева решений. Фундаментальная концепция ансамблевой модели заключается в том, что группа более слабых учащихся объединяет усилия для создания более сильного ученика.

Что такое пакетирование в машинном обучении?

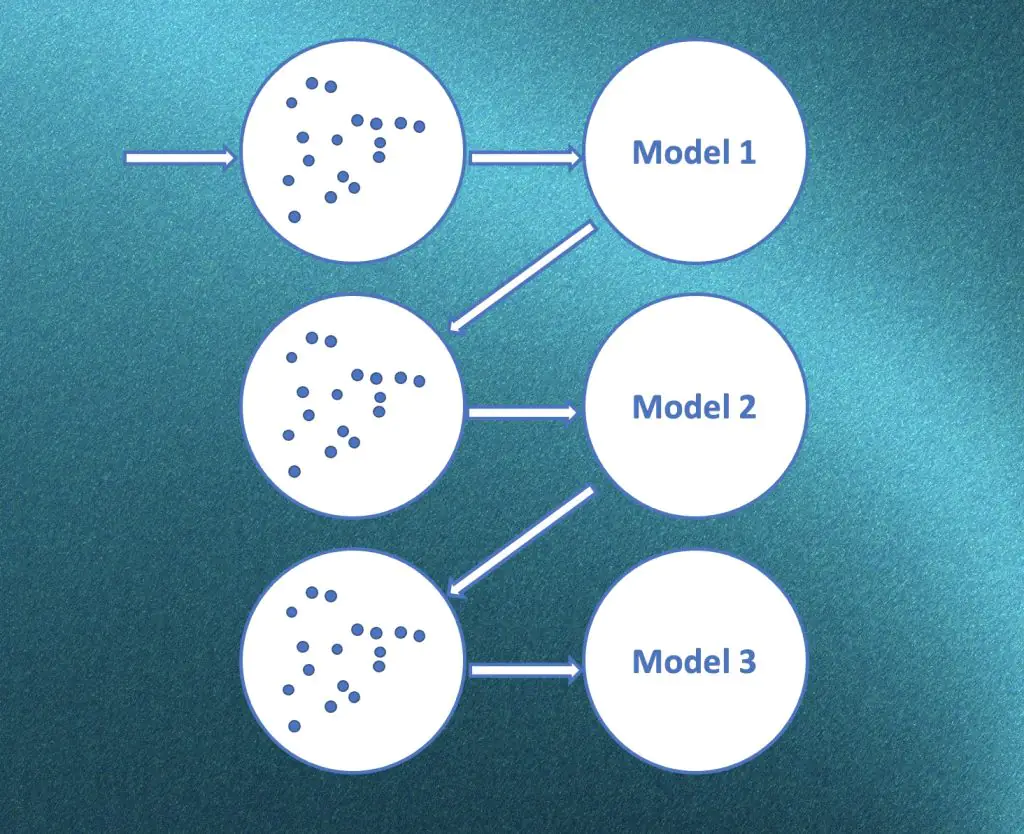

В машинном обучении пакетирование (Bootstrap Aggregating) — это метод, используемый для повышения производительности и надежности прогнозных моделей. Он включает в себя создание нескольких подмножеств обучающих данных путем случайной выборки с заменой. Затем каждое подмножество используется для обучения отдельной модели, а их прогнозы объединяются для получения окончательного прогноза.

Основная идея пакетирования заключается в том, чтобы внести разнообразие в модели, предоставляя им доступ к различным подмножествам обучающих данных. Это помогает сократить переобучение и улучшить обобщение за счет усреднения погрешностей отдельных моделей.

Вот пошаговое объяснение того, как работает пакетирование:

- Выборка данных: Случайные подмножества обучающих данных создаются путем выборки с заменой. Каждое подмножество, известное как загрузочная выборка, имеет тот же размер, что и исходный обучающий набор.

- Обучение модели: для каждого образца начальной загрузки обучается отдельная модель. Модели могут быть одного типа (с использованием одного и того же алгоритма обучения) или разных типов.

- Независимость от модели: Каждая модель обучается независимо от других, что означает, что они ничего не знают о прогнозах друг друга или процессе обучения.

- Комбинация прогнозов: Во время прогнозирования каждая отдельная модель делает свой собственный прогноз на основе тестовых данных. Окончательный прогноз обычно определяется путем агрегирования прогнозов всех моделей либо путем голосования большинством голосов (для задач классификации), либо усреднения (для задач регрессии).

Пример пакетирования в машинном обучении:

Давайте рассмотрим пример пакетирования с использованием алгоритма случайного леса, который является популярным ансамблевым методом, основанным на пакетировании.

Предположим, у нас есть набор данных о клиентах, включая такие характеристики, как возраст, доход и покупательское поведение, и мы хотим построить прогностическую модель, чтобы классифицировать клиентов либо как «оттокных», либо как «не оттокающих» (указывая, например, на то, уйдут они или останутся в сервисе).

В процессе пакетирования с помощью Random Forest мы выполняем следующие действия:

- Выборка данных: Случайные подмножества обучающих данных создаются путем выборки с заменой. Например, мы могли бы случайным образом выбрать 70% исходных данных для каждой начальной выборки. Каждое подмножество будет иметь тот же размер, что и исходный обучающий набор, но может содержать повторяющиеся экземпляры из-за выборки с заменой.

- Обучение модели: Мы обучаем отдельную модель дерева решений для каждого образца начальной загрузки. Каждое дерево решений обучается на разных подмножествах данных, и они могут иметь разные внутренние структуры из-за случайности, привносимой выборкой.

- Независимость от модели: Каждая модель дерева решений обучается независимо от других. Они ничего не знают о прогнозах друг друга или процессе обучения. Каждое дерево может свободно изучать различные шаблоны и взаимосвязи внутри данных.

- Комбинация прогнозов: Во время прогнозирования каждая модель дерева решений делает свой собственный прогноз на основе тестовых данных. Для задач классификации окончательный прогноз может быть определен большинством голосов. Каждое дерево «голосует» за предсказанный класс, и класс, набравший наибольшее количество голосов, становится окончательным прогнозом. Альтернативно, для задач регрессии прогнозы всех деревьев могут быть усреднены для получения окончательного прогноза.

Совокупность деревьев решений, созданных с помощью пакетирования (Случайный лес), как правило, обеспечивает лучшую точность прогнозирования и надежность по сравнению с единым деревом решений. Отдельные деревья принятия решений могут иметь разные сильные и слабые стороны, но их сочетание помогает снизить переобучение и повысить производительность обобщения.

Обратите внимание, что Случайный лес — это лишь один из примеров пакетирования в машинном обучении. Пакетирование может применяться и к другим алгоритмам, таким как методы бустинга, такие как AdaBoost или Gradient Boosting, где основное внимание уделяется созданию ансамбля моделей с различными присвоенными им весами.

Что такое бустинг в машинном обучении?

Бустинг — это метод ансамбля машинного обучения, который объединяет несколько слабых или базовых моделей для создания надежной прогностической модели. В отличие от пакетирования, которое фокусируется на создании разнообразных моделей посредством параллельного обучения, boosting фокусируется на последовательном повышении производительности отдельных моделей.

Основная идея бустинга заключается в обучении серии слабых моделей, обычно деревьев решений, в которых каждая последующая модель фокусируется на исправлении ошибок, допущенных предыдущими моделями. Другими словами, модели обучаются итеративно, и каждая итерация придает больший вес или важность выборкам, которые были неправильно классифицированы предыдущими моделями.

Вот высокоуровневое объяснение того, как работает бустинг:

- Обучение модели: Первоначально первая слабая модель обучается на исходных обучающих данных. Она может работать плохо, поскольку считается слабым обучаемым. Слабые обучаемые — это модели, которые работают немного лучше, чем случайное угадывание.

- Назначение веса: После обучения первой модели неправильно классифицированным образцам присваиваются более высокие веса, в то время как правильно классифицированным образцам присваиваются более низкие веса. Такое распределение веса подчеркивает важность неправильно классифицированных выборок, побуждая последующие модели сосредоточиться на этих выборках.

- Итеративное обучение: обучаются последующие слабые модели, при этом в каждой модели больше внимания уделяется неправильно классифицированным образцам. Модели обучаются последовательно, что означает, что в процессе обучения учитываются результаты предыдущих моделей.

- Обновление веса: веса выборок обновляются после каждой итерации в зависимости от производительности предыдущих моделей. Неправильно классифицированные образцы получают более высокие веса, что позволяет последующим моделям уделять этим образцам больше внимания.

- Комбинация прогнозов: Во время прогнозирования окончательный прогноз определяется путем объединения прогнозов всех слабых моделей. Отдельные прогнозы могут быть взвешены в соответствии с производительностью соответствующих моделей.

Совокупность слабых моделей, созданных с помощью бустинга, как правило, дает сильную прогностическую модель с повышенной точностью. Популярные алгоритмы бустинга включают AdaBoost (адаптивный бустинг) и Gradient Boosting с такими вариациями, как XGBoost и LightGBM.

Бустинг эффективен, когда слабые модели просты и имеют низкую сложность, и когда их можно быстро обучить. Итеративный характер бустинга помогает уменьшить предвзятость и повысить производительность обобщения, сосредоточившись на труднопрогнозируемых выборках.

Разница между пакетированием и бустингом в машинном обучении

Пакетирование и бустинг — это ансамблевые методы, используемые в машинном обучении, но они различаются подходами к объединению нескольких моделей и нацеленностью на уменьшение различных источников ошибок. Вот ключевые различия между пакетированием и бустингом.:

1. Подход к обучению:

- Пакетирование: Пакетирование предполагает обучение нескольких моделей независимо и параллельно. Каждая модель обучается на отдельном подмножестве обучающих данных, полученных путем случайной выборки с заменой. Модели, как правило, одного типа и используют один и тот же алгоритм обучения.

- Бустинг: Бустинг обучает модели последовательно, где каждая последующая модель фокусируется на исправлении ошибок, допущенных предыдущими моделями. Каждая модель обучается на полных обучающих данных, но важность выборок корректируется в зависимости от эффективности их классификации на предыдущих итерациях.

2. Взвешивание образцов:

- Пакетирование: При пакетировании каждая модель обучается на случайном подмножестве данных с заменой, и все выборки во время обучения имеют одинаковый вес. Нет никакого акцента на исправлении ошибок, допущенных отдельными моделями.

- Бустинг: Бустинг присваивает обучающим выборкам разные веса. Изначально все выборки имеют равные веса, но неправильно классифицированные выборки получают более высокие веса на последующих итерациях, что позволяет последующим моделям уделять больше внимания исправлению этих ошибок.

3. Комбинация моделей:

- Пакетирование: При пакетировании прогнозы отдельных моделей объединяются путем голосования большинством голосов (для задач классификации) или усреднения (для задач регрессии). Каждая модель вносит равный вклад в окончательное предсказание.

- Бустинг: В бустинге предсказания отдельных моделей объединяются путем придания их прогнозам разного веса. Модели с более высокой производительностью обычно получают более высокие веса, а окончательный прогноз получается путем взвешенного усреднения или суммирования прогнозов.

4. Фокус на уменьшении ошибок:

- Пакетирование: Пакетирование направлено на уменьшение дисперсии моделей путем создания разнообразных моделей с помощью случайной выборки. Это помогает улучшить стабильность и обобщенность моделей за счет сокращения переобучения.

- Бустинг: Бустинг направлен на уменьшение предвзятости моделей путем последовательного исправления ошибок, допущенных предыдущими моделями. Это помогает повысить общую точность и прогностическую способность ансамбля, сосредоточив внимание на труднопрогнозируемых выборках.

Популярные алгоритмы, основанные на пакетировании, включают Случайный лес, в котором несколько деревьев решений обучаются независимо и комбинируются. С другой стороны, популярные алгоритмы бустинга включают AdaBoost (адаптивный бустинг) и Gradient Boosting, где модели обучаются последовательно и взвешиваются в зависимости от их производительности.

Заключение

Пакетирование и бустинг — это совокупные методы, используемые в машинном обучении для повышения эффективности прогнозирования. Пакетирование направлено на уменьшение дисперсии путем создания разнообразных моделей путем параллельного обучения и объединения их прогнозов, в то время как бустинг направлен на уменьшение предвзятости путем последовательного обучения моделей, исправляющих ошибки, допущенные предыдущими моделями. Пакетирование объединяет модели в равной степени, в то время как бустинг присваивает моделям веса в зависимости от их производительности. Случайный лес — популярный пример пакетирования, в то время как AdaBoost и Gradient Boosting являются распространенными алгоритмами бустинга.

Часто задаваемые вопросы, связанные с пакетированием и бустингом в машинном обучении

Вопрос 1. Какая техника ансамбля лучше, пакетирование или бустинг?

Выбор между пакетированием и бустингом зависит от конкретной проблемы и набора данных. Пакетирование эффективно, когда базовые модели склонны к переоснащению, в то время как бустинг полезен, когда базовые модели слишком слабые и нуждаются в улучшении. Рекомендуется поэкспериментировать с обоими методами и выбрать тот, который обеспечивает лучшую производительность для данной задачи.

Вопрос 2. Можно ли применить пакетирование и бустинг к любому алгоритму машинного обучения?

Да, пакетирование и бустинг могут применяться к различным алгоритмам машинного обучения, включая деревья решений, нейронные сети и машины опорных векторов. Однако деревья решений обычно используются для слабых учеников как при пакетировании (Случайный лес), так и при бустинге (AdaBoost, градиентный бустинг) из-за их простоты и интерпретируемости.

Вопрос 3. Сокращают ли пакетирование и бустинг переобучение?

Да, и пакетирование, и бустинг помогают снизить переобучение, но с помощью разных механизмов. Пакетирование сокращает переобучение за счет создания разнообразных моделей с помощью случайной выборки, в то время как бустинг сокращает переобучение за счет итеративного исправления ошибок, допущенных предыдущими моделями, и сосредоточения внимания на выборках, которые трудно предсказать.

Вопрос 4. Подходят ли пакетирование и бустинг для несбалансированных наборов данных?

Как пакетирование, так и бустинг могут обрабатывать несбалансированные наборы данных, но их эффективность может быть разной. Пакетирование может помочь, обеспечивая более сбалансированное представление класса меньшинства в каждом подмножестве, в то время как бустинг может сосредоточиться на правильной классификации класса меньшинства путем присвоения более высоких весов неправильно классифицированным выборкам.

Вопрос 5. Можно ли использовать пакетирование и бустинг вместе?

Да, пакетирование и бустинг можно комбинировать для создания комплексной техники, называемой «пакетирование с бустингом». При таком подходе пакетирование применяется для создания разнообразных моделей, а затем бустинг используется для дальнейшего повышения их производительности путем последовательного их обучения и корректировки веса выборки.