Что такое веб-очистка и как ее использовать?

В современную цифровую эпоху Интернет служит беспрецедентным хранилищем информации, охватывающим множество данных, начиная от сведений о продуктах и новостных статьях и заканчивая ценами на акции и списками недвижимости. Навигация по этому огромному океану данных может оказаться непосильной задачей, особенно при попытке получить доступ к определенной информации для анализа, исследования или принятия решений. Именно здесь возникает концепция веб-очистки как преобразующего метода, позволяющего нам эффективно извлекать, обрабатывать и использовать ценные данные с веб-сайтов. В этой статье мы углубляемся в мир веб-очистки, исследуя ее механику, приложения, преимущества, проблемы и этические соображения.

Что такое веб-очистка?

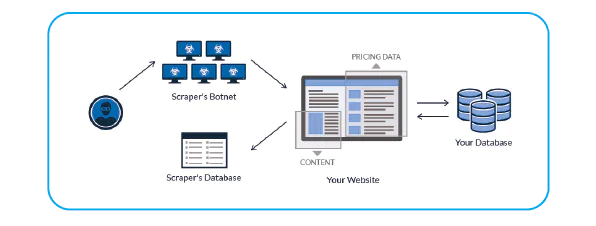

По своей сути веб-очистка включает автоматическое извлечение данных с веб-сайтов. Для навигации по веб-страницам, определения релевантного контента и извлечения нужной информации используются специализированные инструменты, скрипты или программное обеспечение. Затем извлеченные данные структурируются в формат, подходящий для анализа, что делает его мощным методом получения больших объемов данных из Интернета.

Механика веб-очистки

Веб-скрапинг возник как преобразующий метод извлечения ценных данных из необъятных просторов Интернета. По мере того, как мы углубляемся в механику веб-очистки, мы раскрываем сложные этапы, связанные с этим процессом, проливая свет на тонкости, которые позволяют беспрепятственно извлекать информацию с веб-сайтов.

1. Отправка HTTP-запросов

Процесс веб-очистки начинается с отправки запросов HTTP (Hypertext Transfer Protocol) на целевой веб-сайт. Когда пользователь получает доступ к веб-странице, его браузер отправляет HTTP-запрос веб-серверу, который в ответ отправляет обратно HTML-содержимое страницы. При веб-очистке специализированные инструменты и библиотеки повторяют этот процесс для программного извлечения содержимого HTML.

2. Синтаксический анализ HTML-контента

После получения содержимого HTML следующим шагом является синтаксический анализ. Синтаксический анализ включает в себя анализ HTML-кода для понимания его структуры и взаимосвязей. Именно здесь вступают в игру такие библиотеки, как Beautiful Soup и xml в Python. Эти библиотеки позволяют разработчикам перемещаться по структуре HTML, находить конкретные элементы и извлекать нужные данные.

3. Извлечение данных

После анализа содержимого HTML и понимания структуры инструмент веб-очистки идентифицирует и извлекает соответствующие данные. Это может включать текст, изображения, ссылки, таблицы и многое другое. Извлечение данных часто включает в себя использование селекторов, которые представляют собой шаблоны, используемые для определения местоположения определенных элементов в HTML. CSS-селекторы и XPath являются распространенными методами указания элементов для извлечения.

4. Преобразование данных

Извлеченные данные обычно находятся в необработанном виде и должны быть преобразованы в структурированный формат для анализа. Это может включать очистку от ненужных символов, преобразование типов данных и организацию данных по строкам и столбцам. Преобразование данных гарантирует, что очищенная информация готова к дальнейшей обработке, анализу или хранению.

5. Обработка динамического контента

Сегодня веб-сайты часто используют методы динамической загрузки контента, такие как JavaScript, для улучшения пользовательского опыта. Традиционные инструменты веб-очистки могут с трудом захватывать этот контент, поскольку они извлекают только начальный HTML-код. Для решения этой проблемы разработчики могут использовать безголовые браузеры, такие как Puppeteer или Selenium, которые отображают веб-страницы так, как это делал бы настоящий браузер. Это позволяет извлекать данные из динамически генерируемого контента.

6. Разбивка на страницы и навигация

При очистке нескольких страниц веб-сайта решающее значение приобретают разбивка на страницы и навигация. Инструменты веб-очистки необходимы для навигации по различным страницам результатов поиска, спискам товаров или статьям, чтобы обеспечить всесторонний сбор данных. Разбиение на страницы управляется путем создания URL-адресов с различными параметрами и перехода по ним.

7. Обращение с капчами и меры по предотвращению очистки

Некоторые веб-сайты используют меры безопасности, такие как CAPTCHA (полностью автоматизированный публичный тест Тьюринга, позволяющий отличать компьютеры от людей), чтобы предотвратить автоматическую очистку. Для преодоления этих проблем часто требуются передовые методы, такие как использование сервисов для решения КАПЧИ или применение алгоритмов машинного обучения для расшифровки капч.

8. Обработка ошибок и надежность

Веб-очистка не всегда проходит гладко. Веб-сайты могут изменять свою структуру, испытывать простои или возвращать ошибки. Эффективная веб-очистка предполагает внедрение механизмов обработки ошибок для решения этих ситуаций и обеспечения бесперебойного продолжения процесса очистки.

Как использовать веб-очистку?

Эффективное использование веб-очистки предполагает сочетание понимания процесса, выбора правильных инструментов и библиотек, а также учета этических и юридических соображений. Вот пошаговое руководство по использованию веб-очистки:

1. Разберитесь в веб-сайте и требованиях к данным:

Прежде чем приступить к веб-очистке, определите свои цели. Поймите структуру веб-сайта, данные, которые вы хотите извлечь, и как вы планируете использовать эти данные. Это поможет вам определить масштаб и сложность вашего проекта очистки.

2. Выберите язык программирования:

Выберите язык программирования, подходящий для веб-очистки. Python является одним из самых популярных вариантов благодаря своей богатой экосистеме библиотек, включая Beautiful Soup, lxml и requests, которые широко используются для целей очистки.

3. Выберите правильные инструменты и библиотеки:

Выбирайте библиотеки веб-очистки, соответствующие выбранному вами языку программирования. Например, если вы используете Python, Beautiful Soup и lxml отлично подходят для синтаксического анализа содержимого HTML. Рассмотрите возможность использования библиотек, таких как Selenium, для обработки динамического контента или взаимодействия с веб-сайтами, которые в значительной степени зависят от JavaScript.

4. Установите необходимые библиотеки:

После того, как вы выбрали свои инструменты и библиотеки, установите их с помощью менеджеров пакетов, таких как pip (Python), чтобы убедиться, что у вас есть необходимые инструменты для запуска вашего проекта scraping.

5. Отправка HTTP-запросов:

Используйте библиотеки, подобные requests, для отправки HTTP-запросов на веб-сайт, который вы хотите очистить. Эти запросы будут извлекать HTML-содержимое веб-страниц, из которых вы хотите извлечь данные.

6. Синтаксический анализ HTML-контента:

Используйте библиотеки синтаксического анализа, такие как Beautiful Soup, для навигации и разбора содержимого HTML. Это включает в себя идентификацию элементов с помощью CSS-селекторов или XPath и извлечение нужных данных.

7. Извлечение и преобразование данных:

Извлеките соответствующие данные из проанализированного HTML-кода, используя определенные вами селекторы. Затем преобразуйте извлеченные данные в структурированный формат, такой как CSV или JSON-файл, чтобы сделать его пригодным для анализа.

8. Обработка динамического контента:

Если веб-сайт использует динамический контент, загружаемый с помощью JavaScript, рассмотрите возможность использования безголовых браузеров, таких как Selenium. Эти инструменты могут отображать веб-страницы, позволяя извлекать данные из элементов, которые генерируются после начальной загрузки HTML.

9. Разбивка на страницы и навигация:

Для очистки нескольких страниц реализуйте логику разбивки на страницы для навигации по разным страницам результатов поиска или списков. Генерируйте URL-адреса с различными параметрами для доступа к разным страницам.

10. Обработка ошибок:

Внедрите механизмы обработки ошибок для решения ситуаций, когда веб-страницы могут меняться, возникать простои или возвращать ошибки. Это гарантирует, что ваш процесс очистки остается надежным и бесперебойным.

11. Этические и юридические соображения:

Соблюдайте условия предоставления услуг веб-сайта и robots.txt файл. Избегайте агрессивной очистки, которая может перегрузить серверы или нарушить предполагаемое использование веб-сайта. Подумайте, являются ли данные, которые вы очищаете, общедоступными и этически допустимыми для использования.

12. Тестируйте и повторяйте:

Протестируйте свой скрипт веб-очистки в небольшом масштабе, прежде чем расширять его. Убедитесь, что ваша логика очистки точна и фиксирует требуемые данные. При необходимости повторите и доработайте свой скрипт для повышения эффективности и точности.

13. Хранение и анализ данных:

Храните скрапированные данные в структурированном формате и анализируйте их с использованием соответствующих инструментов и методик. Визуализируйте данные, чтобы получать информацию и принимать обоснованные решения.

14. Поддерживайте регулярные проверки:

Веб-сайты могут обновлять свою структуру или условия предоставления услуг, что может повлиять на ваш скрипт очистки. Периодически просматривайте и обновляйте свой скрипт, чтобы убедиться, что он продолжает эффективно работать.

Преимущества веб-очистки

Преимущества веб-очистки способствуют ее широкому внедрению:

- Доступность данных Веб-очистка обеспечивает доступ к данным с веб-сайтов, на которых отсутствуют API или загружаемые наборы данных, открывая мир ранее неиспользованной информации.

- Автоматизация повышения эффективности позволяет выполнять очистку больших объемов данных за долю времени, которое потребовалось бы для выполнения вручную, экономя как время, так и усилия.

- Обновления в режиме реального времени Веб-очистка облегчает обновление динамических источников данных в режиме реального времени или частые обновления таких источников данных, как новостные статьи и цены акций.

- Скрапинг для агрегирования и сравнения позволяет собирать данные из нескольких источников, облегчая агрегирование и сравнение для лучшего понимания.

Проблемы и этические соображения

Однако веб-очистка не лишена своих проблем и этических сложностей:

- Юридические соображения Некоторые веб-сайты явно запрещают или ограничивают веб-очистку в своих условиях предоставления услуг, что потенциально приводит к правовым конфликтам.

- Этичное использование Очистка данных без разрешения или их неэтичное использование может вызвать опасения по поводу конфиденциальности и прав интеллектуальной собственности.

- Различия в качестве данных в макетах веб-сайта и изменения в контенте могут привести к получению неточных или неполных данных в процессе очистки.

- Технические препятствия Некоторые веб-сайты используют меры безопасности, такие как CAPTCHA, для предотвращения автоматической очистки, что требует использования передовых методов.

- Перегрузка сервера Агрессивная или неконтролируемая очистка может привести к перегрузке серверов, вызывая сбои как для владельцев веб-сайтов, так и для пользователей.

Заключение

По сути, веб-скрапинг служит мощным инструментом, который изменил то, как мы взаимодействуем с онлайн-информацией и используем ее. Он позволяет компаниям принимать обоснованные решения, помогает исследователям в сборе важных данных и помогает журналистам рассказывать истории, основанные на данных. Тем не менее, крайне важно подходить к веб-очистке ответственно и этично, придерживаясь юридических принципов и уважая условия обслуживания очищаемых веб-сайтов. При разумном использовании веб-скрапинга становится незаменимым ресурсом в современном мире, основанном на данных, стимулируя инновации, позволяя принимать обоснованные решения и способствуя прогрессу в различных секторах.

Редактор: AndreyEx