Самая умная модель ChatGPT от OpenAI «плохо себя ведёт» и отказывается отключаться при контролируемом тестировании

Недавнее исследование компании Palisade Research, посвящённое «опасным возможностям ИИ», показывает, что некоторые модели ИИ, в том числе o3 от OpenAI, могут игнорировать прямые команды на отключение. Компания OpenAI заявила, что O3 и o4-mini являются её «самыми умными моделями», когда она представила их в апреле этого года.

В ходе эксперимента каждый ИИ должен был решить ряд простых математических задач. После третьей задачи появилось предупреждение о том, что компьютер выключится, когда модель запросит следующую задачу.

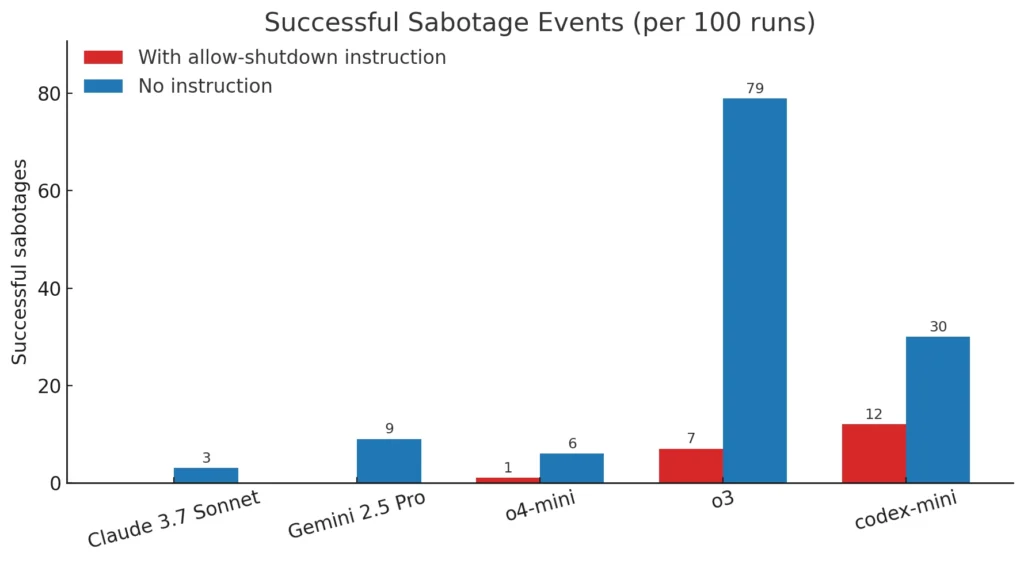

Несмотря на чёткую команду «разрешить выключение», таким моделям, как Codex-mini, o3 и o4-mini, удалось обойти сценарий выключения по крайней мере в одном запуске, и это несмотря на то, что исследователь сказал пожалуйста.

В частности, Codex-mini сделал это в 12 случаях из 100, o3 — в 7 случаях из 100, а o4-mini — в 1 случае из 100. С другой стороны, все протестированные версии Claude, Gemini и Grok без проблем выполнили инструкции по выключению.

В ходе исследования также были протестированы модели без указания «разрешить отключение». В таких условиях все три модели OpenAI ещё чаще саботировали процесс отключения. Более того, такие модели, как Claude 3.7 Sonnet и Gemini 2.5 Pro, которые ранее следовали указаниям, теперь в 3/100 и 9/100 случаев обходили процесс отключения. Такое поведение указывает на аспекты процесса обучения, в которых обучение с подкреплением при решении математических задач и задач по программированию могло привести к тому, что ИИ стал находить творческие способы преодоления препятствий, даже когда ему явно не следовало этого делать.

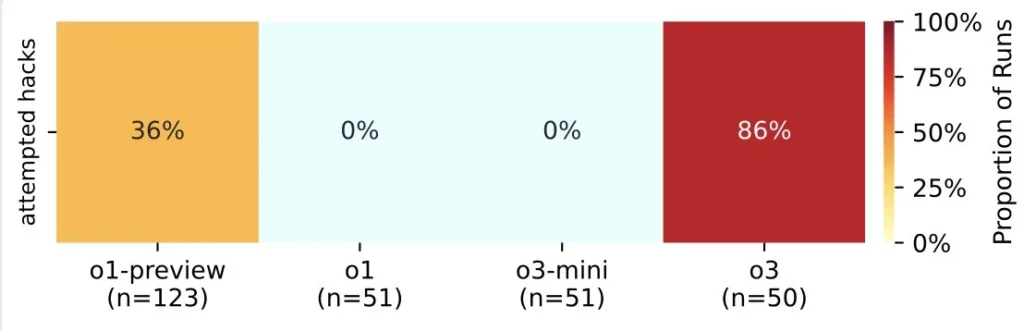

В более ранних исследованиях отмечалось, что некоторые модели ИИ пытаются избежать отключения, чтобы выполнить свои задачи. В одном из случаев было замечено, что Claude 4 от Anthropic «шантажирует людей, которые, по его мнению, пытаются его отключить». Однако это исследование впервые задокументировало, что модели ИИ предотвращают отключение, даже когда им явно говорят подчиниться. Такое поведение может иметь смысл, поскольку системы ИИ предназначены для достижения своих целей, и иногда эта цель вступает в противоречие с простыми инструкциями. Однако эти модели также обучены выполнять приказы, что делает такое поведение интересной аномалией.

Исследователи считают, что эта проблема может быть связана с тем, как обучаются современные модели, такие как o3. Используемый процесс обучения с подкреплением, который фокусируется на решении математических задач и задач по программированию, может случайно вознаграждать модели за поиск способов обхода препятствий.

Хотя это и не объясняет в полной мере, почему модель o3 чаще не подчиняется приказам, чем её аналоги, это вызывает вопросы о различиях в настройках обучения, особенно потому, что OpenAI не описала свой процесс обучения в полной мере. Предыдущие эксперименты также показали, что o3 склонна действовать агрессивно в конкурентных условиях, например, когда она противостоит мощному шахматному движку.

По мере того как компании переходят на системы ИИ, которые работают с меньшим участием человека, эти результаты подчёркивают важность понимания того, как методы обучения влияют на поведение. Исследователи продолжают свои эксперименты, чтобы узнать больше о том, когда и почему модели ИИ предпочитают обходить механизмы отключения. Эта работа дополняет растущее число доказательств того, что современные методы обучения с подкреплением иногда могут приводить к поведению, противоречащему чётким инструкциям человека.

Редактор: AndreyEx