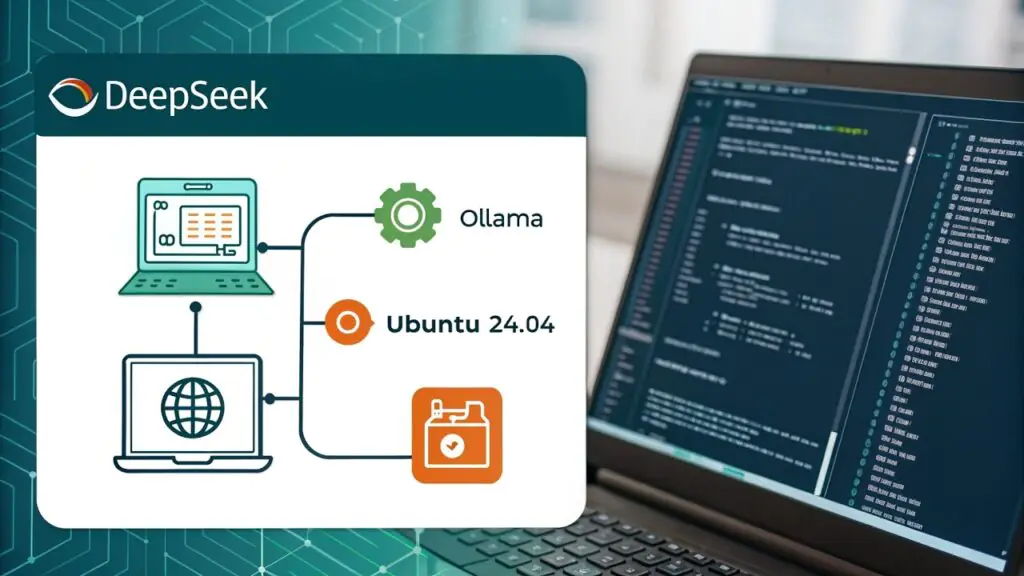

Запуск больших языковых моделей, таких как DeepSeek, локально на вашем компьютере — это эффективный способ изучить возможности ИИ, не полагаясь на облачные сервисы.

В этой статье мы расскажем вам, как установить DeepSeek с помощью Ollama в Ubuntu 24.04 и настроить веб-интерфейс для интерактивного и удобного использования.

Что такое DeepSeek и Ollama?

- DeepSeek: усовершенствованная модель ИИ, предназначенная для обработки естественного языка, например для ответов на вопросы, создания текста и многого другого. .

- Ollama: платформа, которая упрощает локальное использование больших языковых моделей, предоставляя инструменты для управления моделями и взаимодействия с ними, такими как DeepSeek.

- Веб-интерфейс: графический интерфейс, который позволяет взаимодействовать с DeepSeek через браузер, делая его более доступным и удобным для пользователей.

Предварительные условия

Прежде чем мы начнем, убедитесь, что у вас есть следующее:

- На вашем компьютере установлена Ubuntu 24.04.

- Стабильное подключение к Интернету.

- Не менее 8 ГБ оперативной памяти (для более плавной работы рекомендуется 16 ГБ или больше).

- Базовое знакомство с терминалом.

Шаг 1: Установите Python и Git

Прежде чем что-либо устанавливать, рекомендуется обновить систему, чтобы убедиться, что все существующие пакеты обновлены.

sudo apt update && sudo apt upgrade -y

Ubuntu, скорее всего, поставляется с предустановленным Python, но важно убедиться, что у вас установлена правильная версия (Python 3.8 или выше).

sudo apt install python3 python3 --version

pip — это менеджер пакетов для Python, необходимый для установки зависимостей DeepSeek и Ollama.

sudo apt install python3-pip pip3 --version

Git необходим для клонирования репозиториев из GitHub.

sudo apt install git git --version

Шаг 2: Установите Ollama для DeepSeek

Теперь, когда Python и Git установлены, вы готовы установить Ollama для управления DeepSeek.

curl -fsSL https://ollama.com/install.sh | sh ollama --version

Затем запустите Ollama и включите автоматический запуск при загрузке системы.

sudo systemctl start ollama sudo systemctl enable ollama

Теперь, когда Ollama установлена, мы можем приступить к установке DeepSeek.

Шаг 3: Загрузите и запустите модель DeepSeek

Теперь, когда Ollama установлена, вы можете скачать модель DeepSeek.

ollama run deepseek-r1:7b

Это может занять несколько минут в зависимости от скорости вашего интернета, так как размер модели составляет несколько гигабайт.

После завершения загрузки вы можете убедиться, что модель доступна, запустив:

ollama list

Вы должны увидеть deepseek в списке доступных моделей.

Шаг 4: Запустите DeepSeek в веб-интерфейсе

Хотя Ollama позволяет взаимодействовать с DeepSeek через командную строку, вы можете предпочесть более удобный веб-интерфейс. Для этого мы будем использовать Ollama Web UI, простой веб-интерфейс для взаимодействия с моделями Ollama.

Сначала создайте виртуальную среду, которая изолирует ваши зависимости Python от общесистемной установки Python.

sudo apt install python3-venv python3 -m venv ~/open-webui-venv source ~/open-webui-venv/bin/activate

Теперь, когда ваша виртуальная среда активна, вы можете установить Open WebUI с помощью pip.

pip install open-webui

После установки запустите использование сервера.

open-webui serve

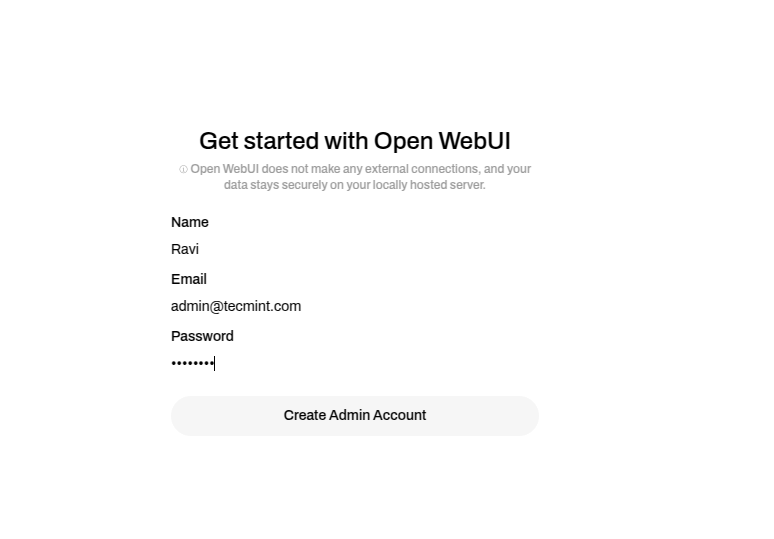

Откройте веб-браузер и перейдите по ссылке http://localhost:8080 — вы увидите интерфейс веб-интерфейса Ollama.

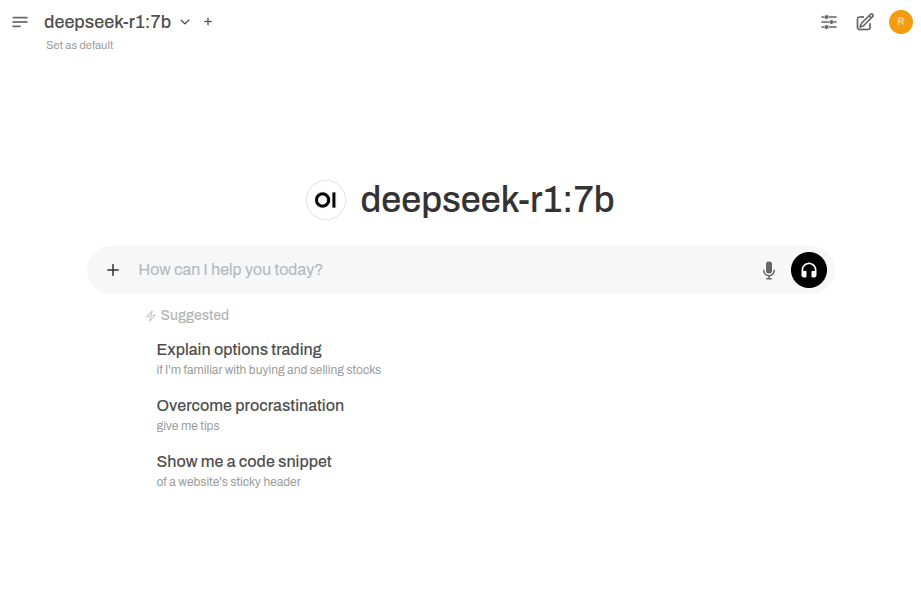

В веб-интерфейсе выберите модель DeepSeek в раскрывающемся меню и начните взаимодействовать с ней. Вы можете задавать вопросы, генерировать текст или выполнять другие задачи, поддерживаемые DeepSeek.

Теперь вы должны увидеть интерфейс чата, в котором вы можете взаимодействовать с DeepSeek, как с ChatGPT.

Заключение

Вы успешно установили Ollama и DeepSeek в Ubuntu 24.04. Теперь вы можете запустить DeepSeek в терминале или использовать веб-интерфейс для более удобной работы.