Живые дипфейковые видео набирают больше просмотров, чем настоящие: что нужно знать

Популярное видео на YouTube, которое вы смотрите в прямом эфире, может быть ненастоящим. Как показала недавняя афера, дипфейковые видео в прямом эфире могут иметь более высокий рейтинг, чем их настоящие версии. Разумеется, они созданы для того, чтобы вас обмануть. Вот что вам нужно знать, чтобы не попасться на удочку мошенников.

В прямом эфире транслируются дипфейковые видео

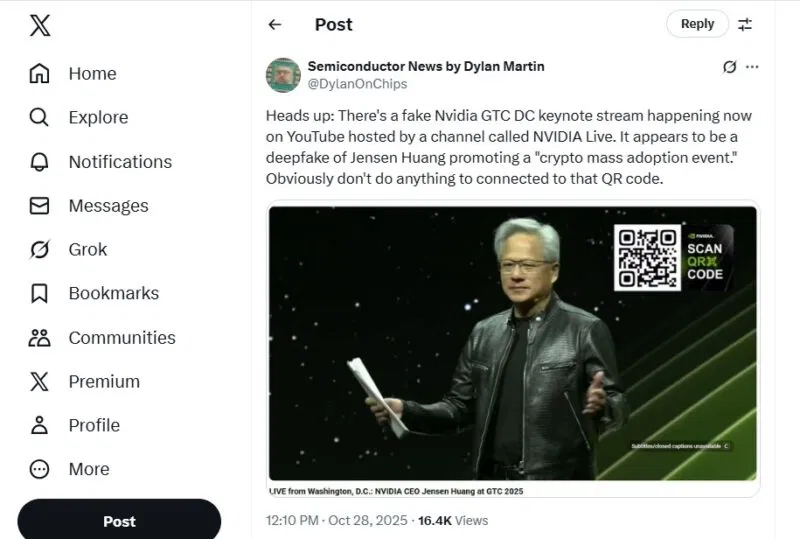

Недавно компания Nvidia провела прямую трансляцию мероприятия GTC. Однако, пока генеральный директор Дженсен Хуанг выступал с основным докладом на официальных каналах, другая версия Хуана привлекала зрителей и отправляла их прямиком в лапы криптомошенников.

Обе прямые трансляции проходили одновременно на YouTube. Хуже всего то, что дипфейк занял более высокое место в рейтинге, чем настоящая прямая трансляция. Название канала, NVIDIA LIVE, вероятно, придавало ему больше правдоподобности. Возможно, именно поэтому он занял такое высокое место в рейтинге. Пользователи, скорее всего, искали «nvidia live», из-за чего YouTube рекомендовал дипфейк вместо настоящего видео.

Дилан Мартин первым забил тревогу по поводу X.

Да, видео было удалено, но пользователь, разместивший его, пока не заблокирован. Это ещё один крупный вид мошенничества, с которым борется YouTube.

Главный урок здесь заключается в том, чтобы не просто нажать на первый результат. Убедитесь, что видео транслируется с нужного канала.

Мошенники намеренно используют распространённые ключевые слова, чтобы их дипфейковые видео в прямом эфире занимали более высокие позиции в результатах поиска. Даже если это работает лишь в течение короткого промежутка времени, мошенникам этого достаточно, чтобы обмануть сотни или тысячи людей за раз.

Тщательно обдумайте то, что вам предлагают

Кто не хочет получить криптовалюту бесплатно? Это знают мошенники. Они знают, что люди хотят получить что-то бесплатно.

Но прямой эфир с дипфейком от Nvidia допустил серьёзную ошибку, по крайней мере для тех, кто помнит, что крупные корпорации не собираются раздавать тонны денег по доброте душевной.

Фальшивый генеральный директор пообещал, что любая криптовалюта, отправленная на кошелёк мошенников, будет волшебным образом конвертирована в биткоины и возвращена. Конвертация означала бы, что вы получите обратно больше, чем отправили.

Ни в коем случае нельзя считать реалистичной идею о том, что Nvidia просто так отдаст миллиарды биткоинов, чтобы хоть как-то помочь зрителям. Компания вкладывает миллиарды в искусственный интеллект, а не в людей.

Прежде чем поверить в то, что вам обещают, хорошенько подумайте. Имеет ли это смысл? Отправляют ли вас на надёжный сайт? Например, если бы криптовалюта была настоящей, разве Nvidia не разместила бы её на своём сайте, а не на сомнительном стороннем ресурсе?

Кроме того, если вас просят отдать деньги, чтобы получить что-то «бесплатно», то это не бесплатно. Это сделка. И это мошенничество.

Дипфейки с использованием ИИ становятся всё более сложными

Изначально дипфейки представляли собой в основном фотографии и короткие видеоролики. Теперь дипфейками могут быть целые прямые трансляции. В них часто используется образ человека, которому доверяют, например, генерального директора Nvidia. ИИ воспроизводит внешний вид, движения и голос человека. Если используется образ хорошо известного человека, то проще собрать данные о нём для обучения ИИ.

Эксперты начинают с трудом отличать реальное от фальшивого. В одном из интервью Хани Фарид, эксперт по искусственному интеллекту, не смог определить, какой из двух голосов был его собственным, а какой — нет.

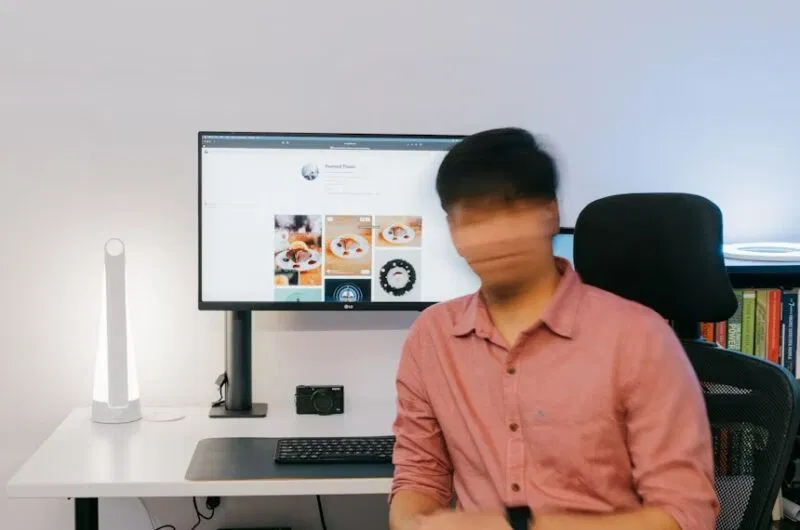

Да, есть признаки, указывающие на то, что фотография, голос или видео являются дипфейками. Но искусственный интеллект становится всё лучше, и заметить эти признаки, такие как неестественные движения, размытость, странные пальцы или уши или постоянное расположение основного объекта на расстоянии, становится всё сложнее.

Простые способы избежать дипфейковых видео в прямом эфире

Если вы просто просматриваете прямую трансляцию, то, скорее всего, не заметите никаких существенных различий. Но это не значит, что вы должны смириться с тем, что никогда не узнаете, настоящая это трансляция или нет.

Вместо этого воспользуйтесь этими простыми правилами, которые помогут вам выбрать настоящие видео:

- Если видео размещено на авторитетной видеоплатформе, такой как YouTube или Twitch, проверьте канал и/или пользователя. Если видео не от официального пользователя или канала, то оно ненастоящее. Сообщите о трансляции или видео и сообщите настоящему каналу о происходящем.

- Увеличьте масштаб. Каким бы невероятным ни был искусственный интеллект, при увеличении масштаба в видео с дипфейками в реальном времени часто наблюдается размытие. Основной объект съёмки находится на расстоянии, поэтому это сложно заметить. Увеличьте масштаб и посмотрите, есть ли размытие вокруг лица и конечностей объекта. Это явный признак подделки.

- Проверьте комментарии. Вам не обязательно быть экспертом в области дипфейков. Просмотрите комментарии и посмотрите, не сомневается ли кто-нибудь ещё в подлинности трансляции. Пользователи, которые уже заметили проблему, часто предупреждают других. Имейте в виду, что спамеры постараются быстро удалить эти комментарии.

- Найдите на YouTube или любом другом сервисе прямых трансляций видео на интересующую вас тему. Если вы увидите аналогичную трансляцию в то же время, посмотрите обе. Скорее всего, одна из них — мошенническая.

- Обычно дипфейк — это видео, которое сильно отклоняется от темы. Например, заявление генерального директора Nvidia о раздаче криптовалюты не имеет никакого смысла. Это всё равно что Microsoft раздавала бы iPhone, но для этого нужно всего лишь предоставить им доступ к вашей учётной записи Microsoft.

Вы также можете использовать инструменты для анализа контента, чтобы определить, является ли он реальным или сгенерированным искусственным интеллектом. Однако они не всегда точны на 100 %. Просто помните о мошенничестве с использованием ИИ и не принимайте видео, фотографии или аудио за чистую монету.

Редактор: AndreyEx